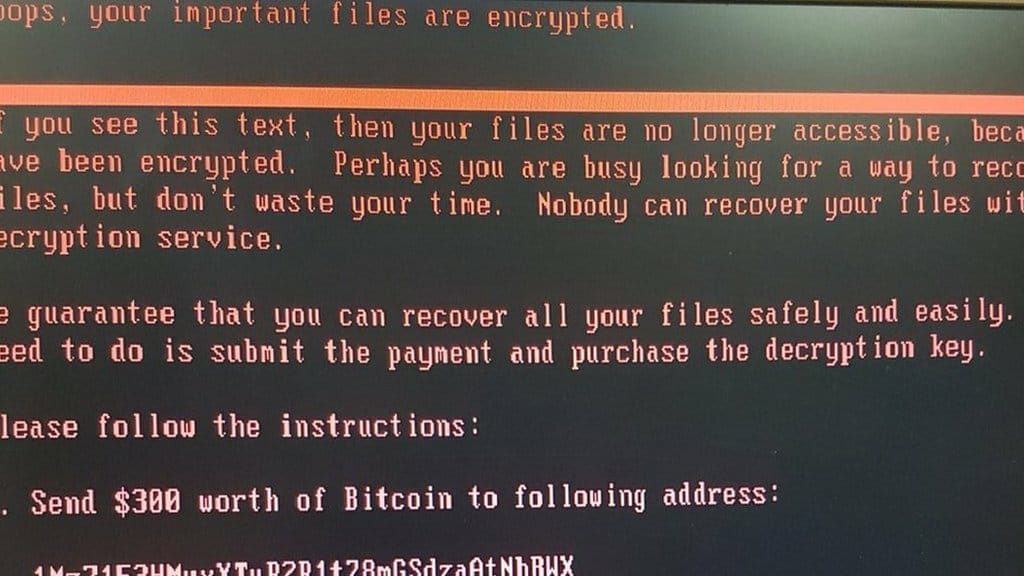

Pierwsza wersja wirusa nazywała się „WannaCry”, obecna „Cryptolocker”. Działanie wirusa jest proste. Użytkownik klika zainfekowany plik, ściągając go z jakiejś strony i oczywiście myśląc, że ściąga coś innego.

w.trampczynski

Dom jest tam, gdzie wifi łączy się samo – mówi dziś popularne internetowe porzekadło. Jeśli spojrzymy na statystyki wielu stron internetowych, to zobaczymy, że znaczny procent odwiedzających używa urządzeń z Androidem na pokładzie (iOS oraz Windows mają znacznie mniejszą popularność). Nasz cyfrowy świat opanowały urządzenia mobilne – tablety, smartfony lub ostatecznie laptopy, które używają prostych i łatwych połączeń wifi. A może za prostych i za łatwych?

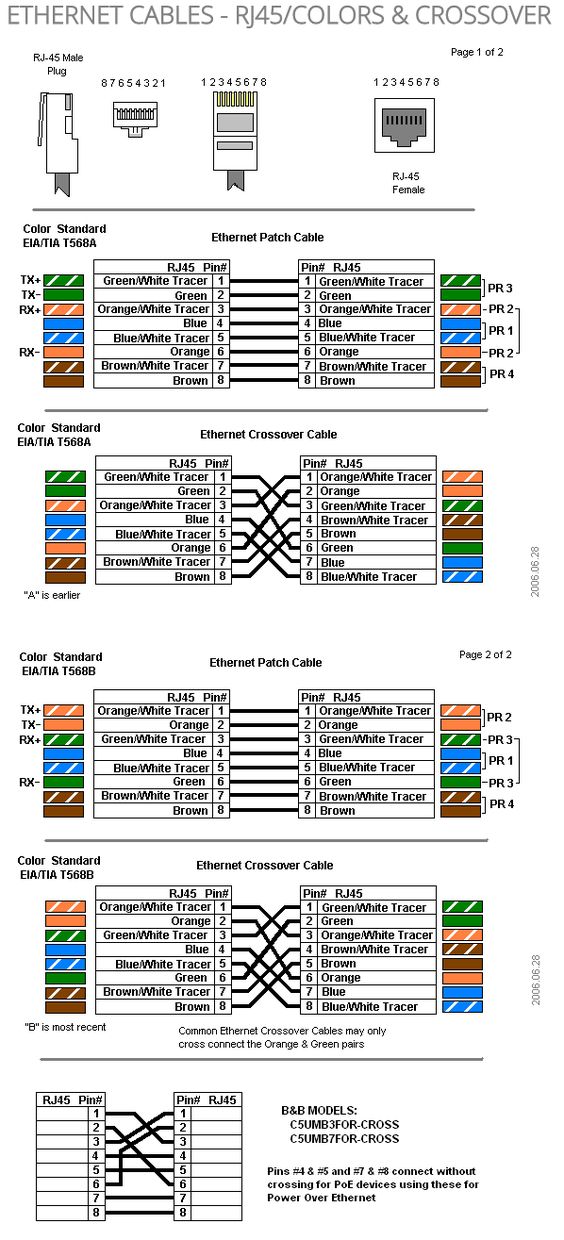

Wiele osób szuka infromacji o tym jak połączyć poszczególne żyły w kablu ethernetowym. Jeśłi ktoś zajmuje się tym na co dzień, to pamięta. A jeśli musimy to zrobić raz na jakiś czas, wtedy zwykle nie jesteśmy pewni. Znalazłem taki przydatny rysunek w sieci.

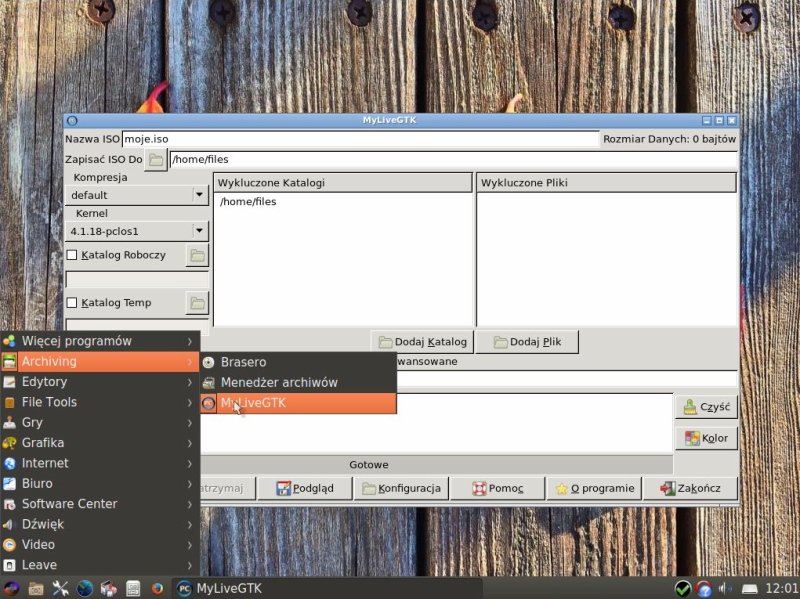

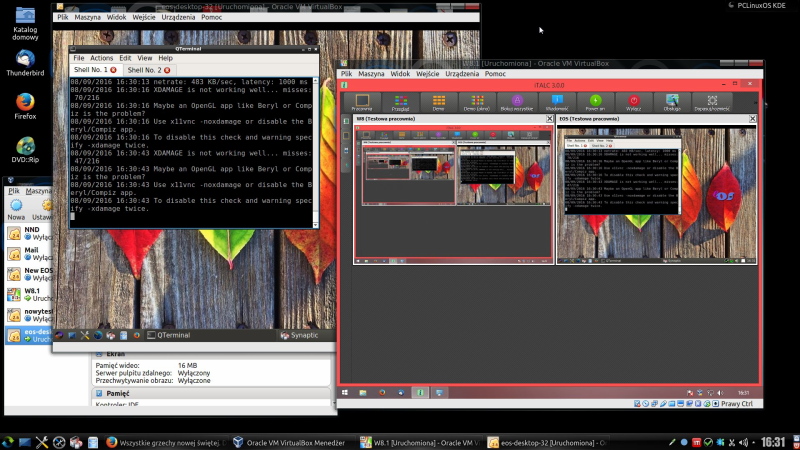

Wersja 32 bitowa systemu EOS to, podobnie jak i inne wersje, system bazujący na PCLinuxOS. Od motywu tapety na pulpicie nazwałem ja roboczo „Jesienne liście”, co nawiasem mówiąc, nie najgorzej łączy się z początkiem roku szkolnego. 😉 Bez wątpienia jest to ostatnia wersja 32 bitowa, ponieważ PCLinuxOS nie będzie rozwijał […]

Wiele szkół ma stare pracownie, które uaktualniane były własnymi środkami. Jednak Windows XP dziś się nie da używać, Visty nie dało się używać nigdy. Stare komputery nadal w szkołach są i często opiekunowie sprzętu są o krok od przeznaczenia ich na złom. A pieniędzy na nowe nie ma. Mamy na […]

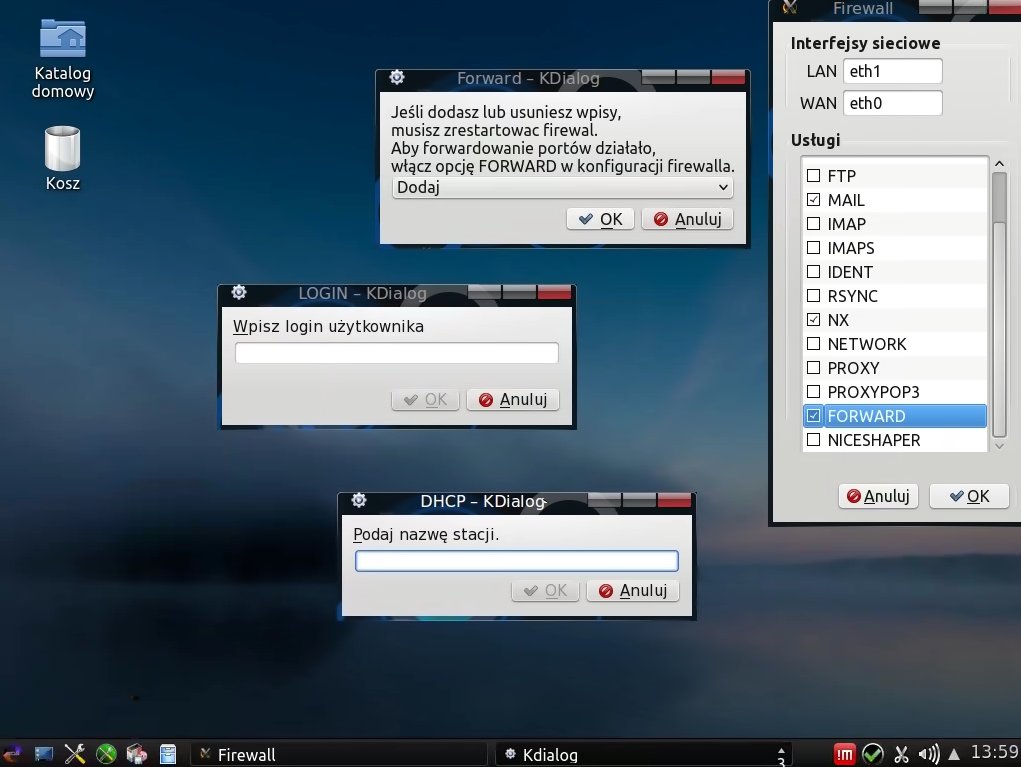

Nie przypuszczałem, że nastąpi dalszy rozwój serwera pod nazwą EOS, ale liczba osób zainteresowanych, o czym świadczyły maile i informacje, które otrzymywałem w ciągu ostatniego roku, była dość spora. Prawdę powiedziawszy byłem nawet zdziwiony… To tyle wstępu, a teraz konkrety: Nowy EOS ma jądro z serii 4.4.X LTS (long term […]

W zasadzie to nic nowego, ale pomyślałem sobie, że może komuś się przydać. #!/bin/bash PRACUJE=`ls /var/lib/clamav |grep clamd.socket |wc -l` if [ $PRACUJE != 0 ]; then echo „CLAMD pracuje” >>/var/log/exim/main.log else echo „CLAMD zdechł” >>/var/log/exim/main.log /sbin/service clamd restart /bin/mailx -s „Clamd Crash” user@adres fi exit 0 Kilka razy zdarzyło […]

Jeśli używacie smartfona, to niezależnie od jego marki i używanego systemu podajecie sami siebie na złotej tacy wszelkim inwigilacyjnym służbom. Twój smartfon loguje się do kolejnych BTS od momentu włączenia, przez cały dzień, i notuje twoją wędrówkę po mieście lub dalszą. Tak, zwykły telefon też to robi. Ale na smartfonie […]

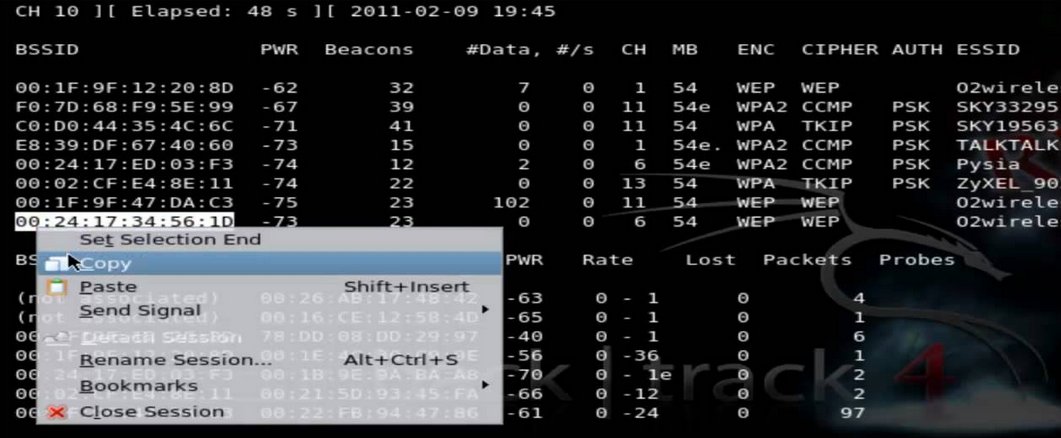

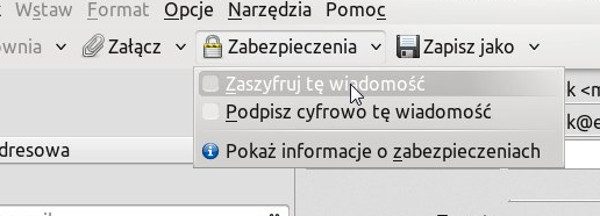

Od niedawna funkcjonuje nowa ustawa, która w zasadzie umożliwia rządowi podsłuchiwać każdego i wszędzie bez praktycznie żadnych ograniczeń, w szczególności zaś zostaliśmy pozbawieni jakiegokolwiek prawa do prywatności w sieci. Jednak nie będę się zajmować polityką, lecz tym – jak pomimo dążeń wielkiego brata zapewnić sobie minimum prywatności. Dziś kilka słów […]

To się zdarza. Instalujemy MySQL, którego na danym serwerze nie używamy i potem problem. Czasem problem występuje dlatego, że przejmujemy serwer po kimś. Jak można temu zaradzić? Najpierw zatrzymujemy daemon MySQL, a potem uruchamiamy mysql tak, by nie trzeba było podawać hasła. service mysqld stop mysqld_safe –no-defaults –skip-grant-tables Następnie na […]